简介

我们提供的StarWind HyperConverged Appliance(HCA),适用于正在寻找减少应用程序停机时间的方法,但受限于IT团队资源和/或预算的中小企业和分支机构。StarWind HCA是一个100%软件定义的超融合平台,采用Dell® OEM或StarWind品牌的服务器平台构建:我们使用Supermicro超级服务器。本文介绍了三个基准测试阶段中的第一个阶段。它展示了12节点可用的StarWind HCA集群性能。

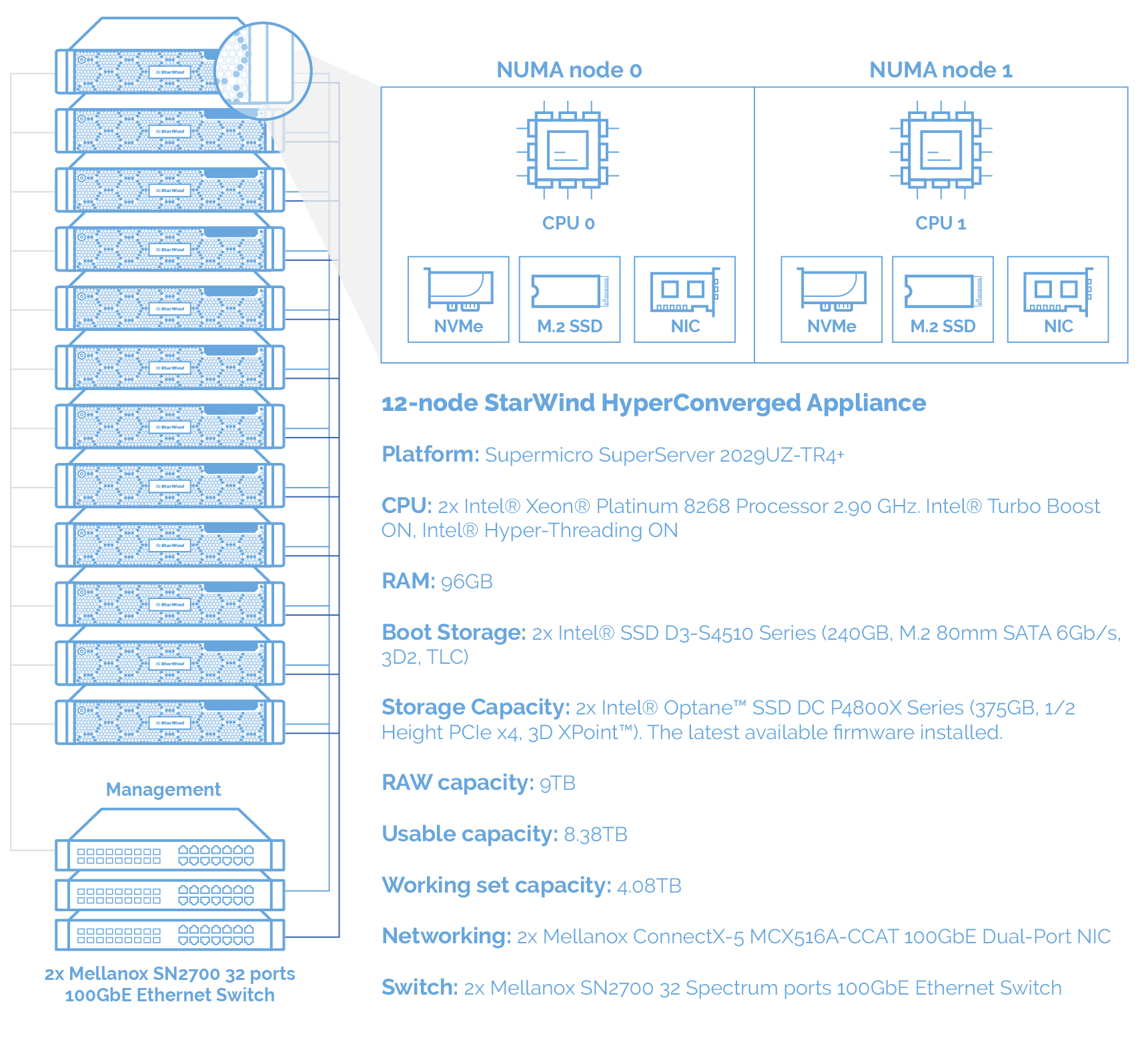

硬件

每个节点都采用了英特尔® Xeon® Platinum 8268处理器、2个英特尔® Optane™ SSD DC P4800X系列硬盘和Mellanox ConnectX-5 100GbE网卡,它们都用Mellanox LinkX®铜缆连接到2个Mellanox SN2700 Spectrum™交换机。一般来说,我们使用的是标准的StarWind HyperConverged Appliances(Supermicro SuperServer机箱),其中只升级了CPU,以追赶人机交互行业的记录。

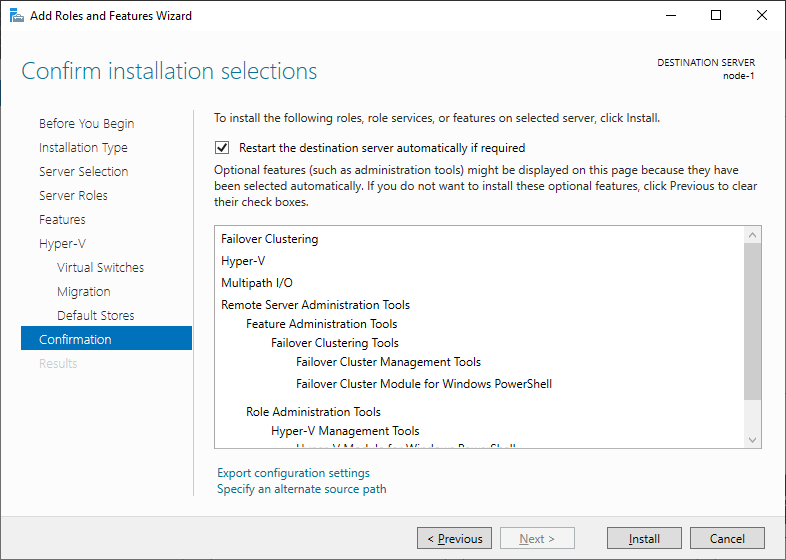

软件

在我们的设置中,StarWind HCA运行最快的软件:Microsoft Hyper-V(Windows Server 2019)和StarWind Virtual SAN服务应用程序在Windows用户区域中运行。 除避免中断驱动的IO外,StarWind还支持轮询,以通过将CPU周期转换为IOPS来减少延迟并提高性能。 我们还开发了TCP回送加速器,以绕过同一台计算机上的TCP堆栈,并开发了iSCSI负载均衡器,以将新的iSCSI会话分配给新的CPU内核,从而解决了Microsoft iSCSI启动器老化的问题。

在我们的网站上,您可以了解有关由StarWind Virtual SAN支持的超融合基础架构的更多信息。

总结

在Supermicro SuperServer平台上封装的12个节点可用的StarWind HCA集群,这是它的第一阶段基准测试结果,每个集群都采用Intel® Xeon® Platinum 8268处理器和Intel® Optane™ SSD DC P4800X系列硬盘,以及Mellanox ConnectX-5 100GbE网卡。

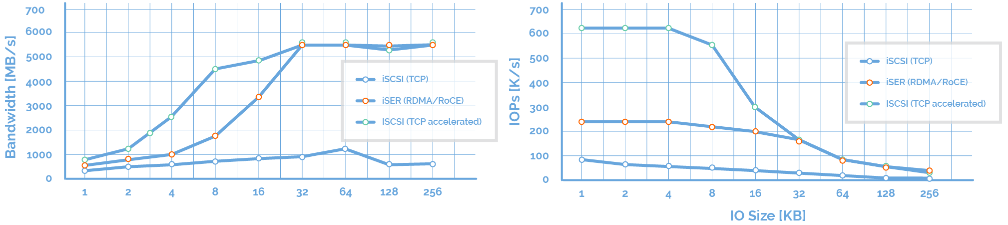

无需缓存有12个节点的HCA集群提供了670万IOPS,是理论上1320万IOPS的51%。这是在纯生产配置下的突破性性能(只使用iSCSI而不使用RDMA进行客户端访问)。主干网在iSER上运行,没有使用任何专有技术。使用纯iSCSI启动器和StarWind Virtual SAN的任何管理程序都可以获得类似的性能结果。

对于下一个基准测试阶段,我们将按照Intel的建议,通过将Intel Optane NVMe SSD配置为缓存设备来最大限度地提高IO性能。

注意: 在每台服务器上,每个NUMA节点都有1个Intel®SSD D3-S4510、1个Intel®Optane™SSD DC P4800X系列和1个Mellanox ConnectX-5 100GbE双端口网卡。 这种配置能够从每个硬件中挤出最大性能。 这样的连接不是推荐而是严格的要求。 为了获得类似的性能,不需要调整NUMA节点配置,这意味着默认设置是可以的。

注意: 在每台服务器上,每个NUMA节点都有1个Intel®SSD D3-S4510、1个Intel®Optane™SSD DC P4800X系列和1个Mellanox ConnectX-5 100GbE双端口网卡。 这种配置能够从每个硬件中挤出最大性能。 这样的连接不是推荐而是严格的要求。 为了获得类似的性能,不需要调整NUMA节点配置,这意味着默认设置是可以的。

驱动程序安装。 固件升级

驱动程序安装。 固件升级 StarWind iSCSI加速器(负载平衡器)。 我们将内置的Microsoft iSCSI Initiator与我们自己的用户模式iSCSI 启动器一起使用。 Microsoft iSCSI启动器是在“石器时代”开发的,当时服务器具有一个或两个插槽的CPU,每个插槽一个内核。 如今拥有更强大的服务器,启动器并没有发挥它应有的作用。

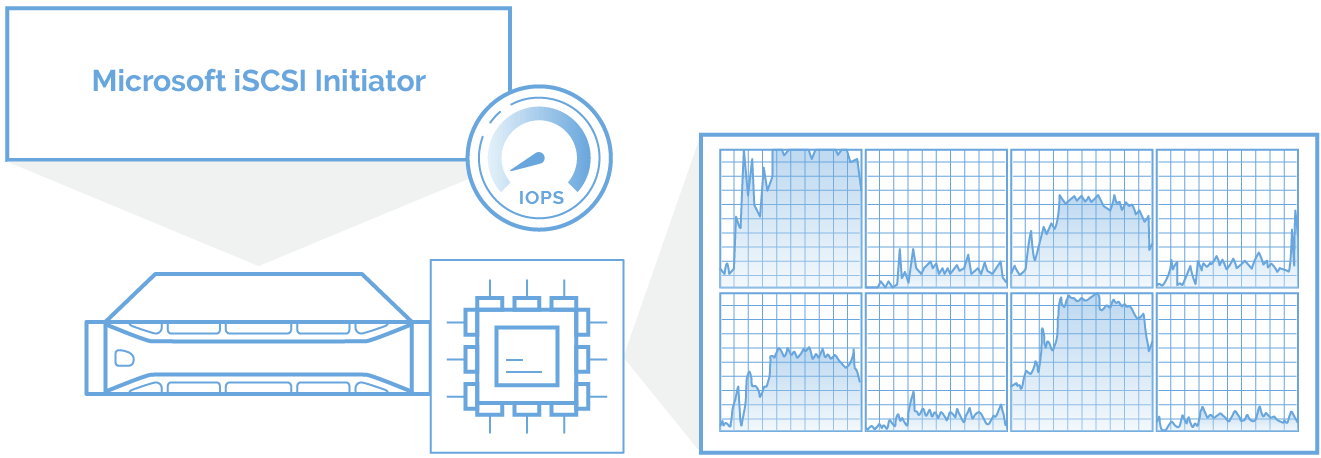

StarWind iSCSI加速器(负载平衡器)。 我们将内置的Microsoft iSCSI Initiator与我们自己的用户模式iSCSI 启动器一起使用。 Microsoft iSCSI启动器是在“石器时代”开发的,当时服务器具有一个或两个插槽的CPU,每个插槽一个内核。 如今拥有更强大的服务器,启动器并没有发挥它应有的作用。

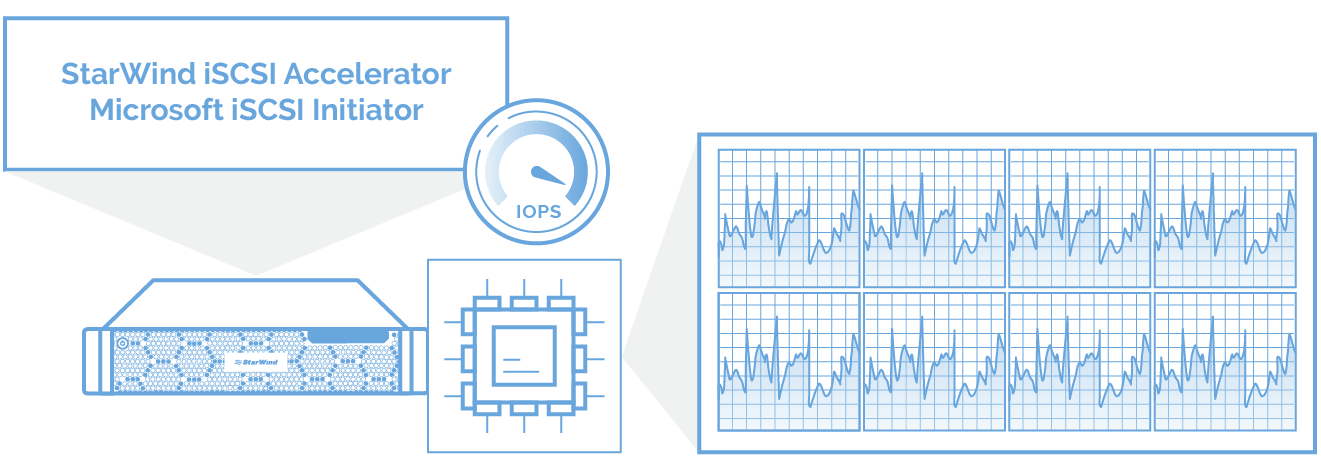

因此,我们开发了iSCSI加速器作为Microsoft iSCSI启动器和网络堆栈之间的筛选器驱动程序。 每次创建新的iSCSI会话时,都会将其分配给空闲的CPU内核。 因此,将统一使用所有CPU内核的性能,并且延迟接近零。 通过这种方式分配工作负载可确保智能计算资源的利用率:没有内核不堪重负,而其他内核则处于空闲状态。

因此,我们开发了iSCSI加速器作为Microsoft iSCSI启动器和网络堆栈之间的筛选器驱动程序。 每次创建新的iSCSI会话时,都会将其分配给空闲的CPU内核。 因此,将统一使用所有CPU内核的性能,并且延迟接近零。 通过这种方式分配工作负载可确保智能计算资源的利用率:没有内核不堪重负,而其他内核则处于空闲状态。

StarWind iSCSI Accelerator(负载均衡器) 安装在每个群集节点上,以平衡Hyper-V服务器中所有CPU内核之间的虚拟化工作负载。

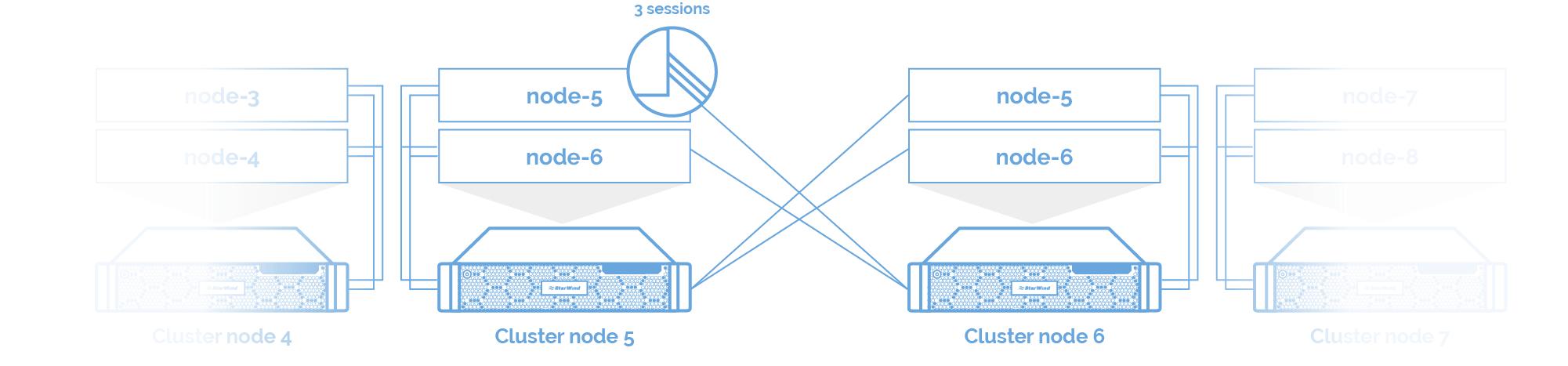

StarWind iSCSI Accelerator(负载均衡器) 安装在每个群集节点上,以平衡Hyper-V服务器中所有CPU内核之间的虚拟化工作负载。 iSCSI/iSER (RDMA)模块 与StarWind HyperConverged Appliances一样,12节点HCI集群采用Mellanox网卡和交换机。在这项研究中,StarWind Virtual SAN利用iSER作为RDMA的主干链路,提供最大可能的性能。

iSCSI/iSER (RDMA)模块 与StarWind HyperConverged Appliances一样,12节点HCI集群采用Mellanox网卡和交换机。在这项研究中,StarWind Virtual SAN利用iSER作为RDMA的主干链路,提供最大可能的性能。 因此,通过RDMA、环回中的DMA和TCP连接的组合,加快了IO性能。

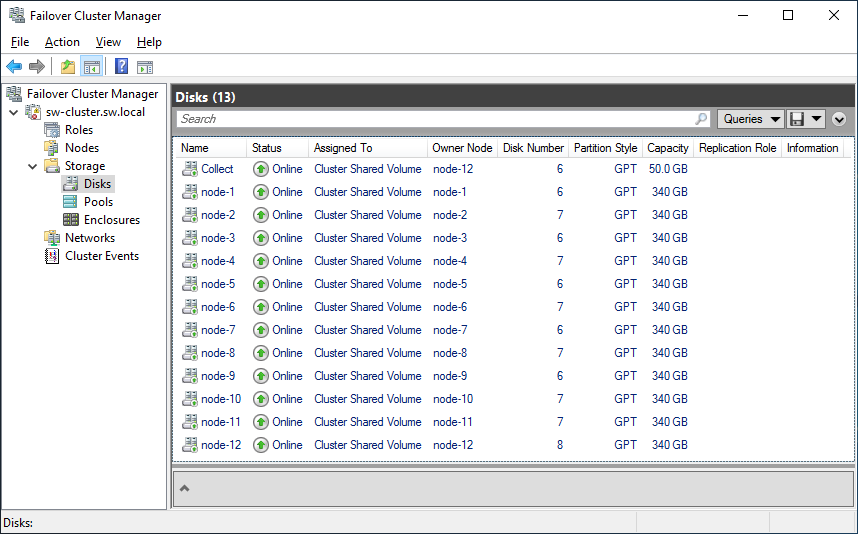

因此,通过RDMA、环回中的DMA和TCP连接的组合,加快了IO性能。 CSV。 对于12节点超融合群集,根据Microsoft的建议,在12个同步镜像的StarWind虚拟磁盘之上创建了12个群集共享卷。

CSV。 对于12节点超融合群集,根据Microsoft的建议,在12个同步镜像的StarWind虚拟磁盘之上创建了12个群集共享卷。

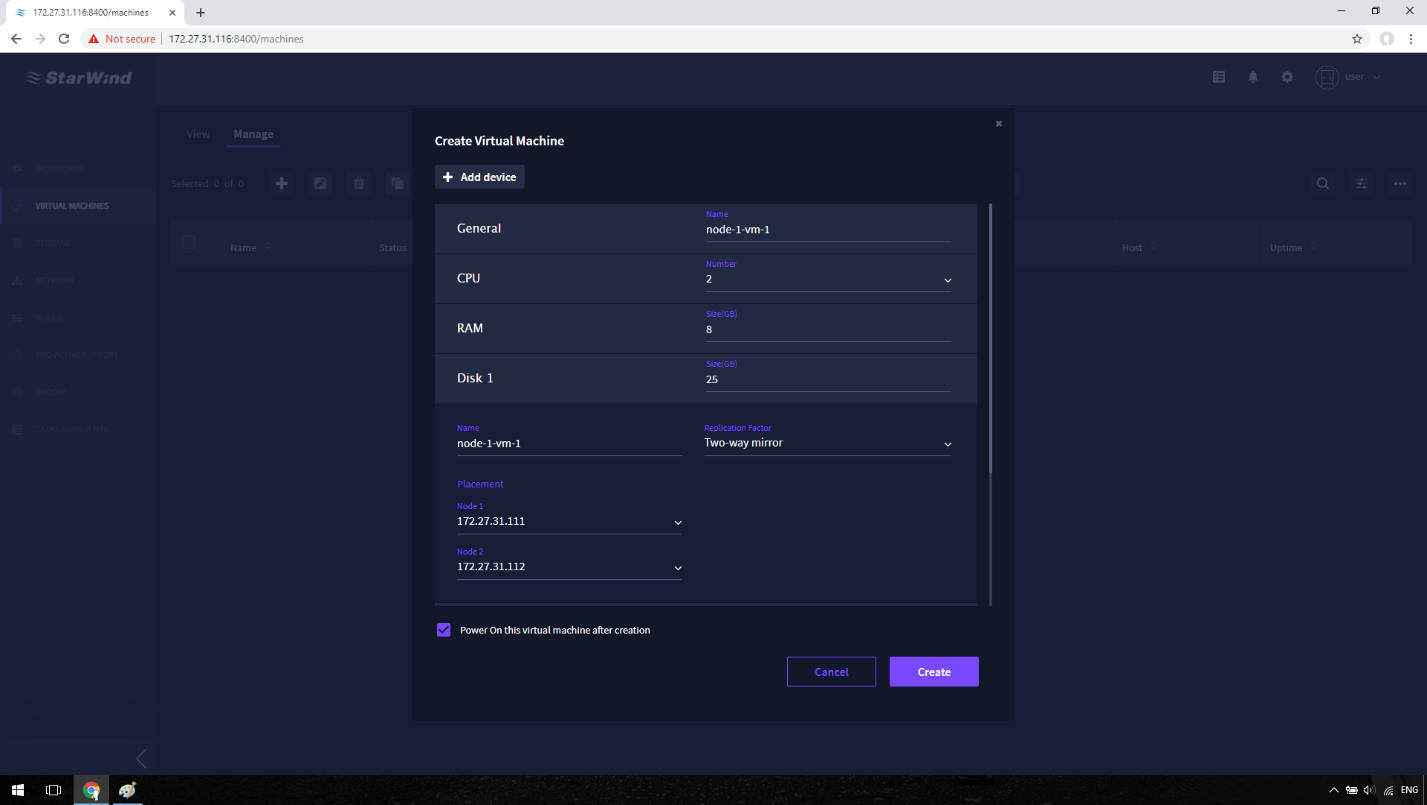

Hyper-V虚拟机。 根据经验归纳,我们取12个虚拟机×每2个虚拟处理器=24个虚拟处理器,以使所有性能饱和。这就是12个服务器节点上总共144个Hyper-V Gen 2虚拟机。每个虚拟机运行Windows Server 2019标准版,并被分配了2 GiB的内存。

Hyper-V虚拟机。 根据经验归纳,我们取12个虚拟机×每2个虚拟处理器=24个虚拟处理器,以使所有性能饱和。这就是12个服务器节点上总共144个Hyper-V Gen 2虚拟机。每个虚拟机运行Windows Server 2019标准版,并被分配了2 GiB的内存。

注意: 已禁用NUMA扩展,以确保虚拟机始终根据有关NUMA扩展的已知事实始终以最佳性能运行。

注意: 已禁用NUMA扩展,以确保虚拟机始终根据有关NUMA扩展的已知事实始终以最佳性能运行。

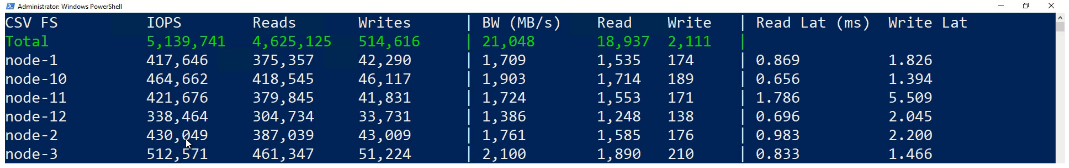

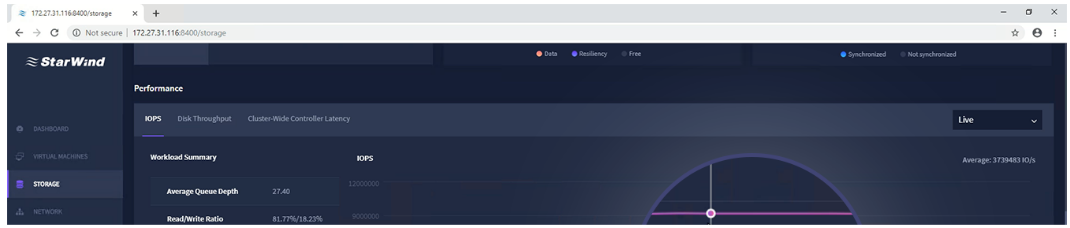

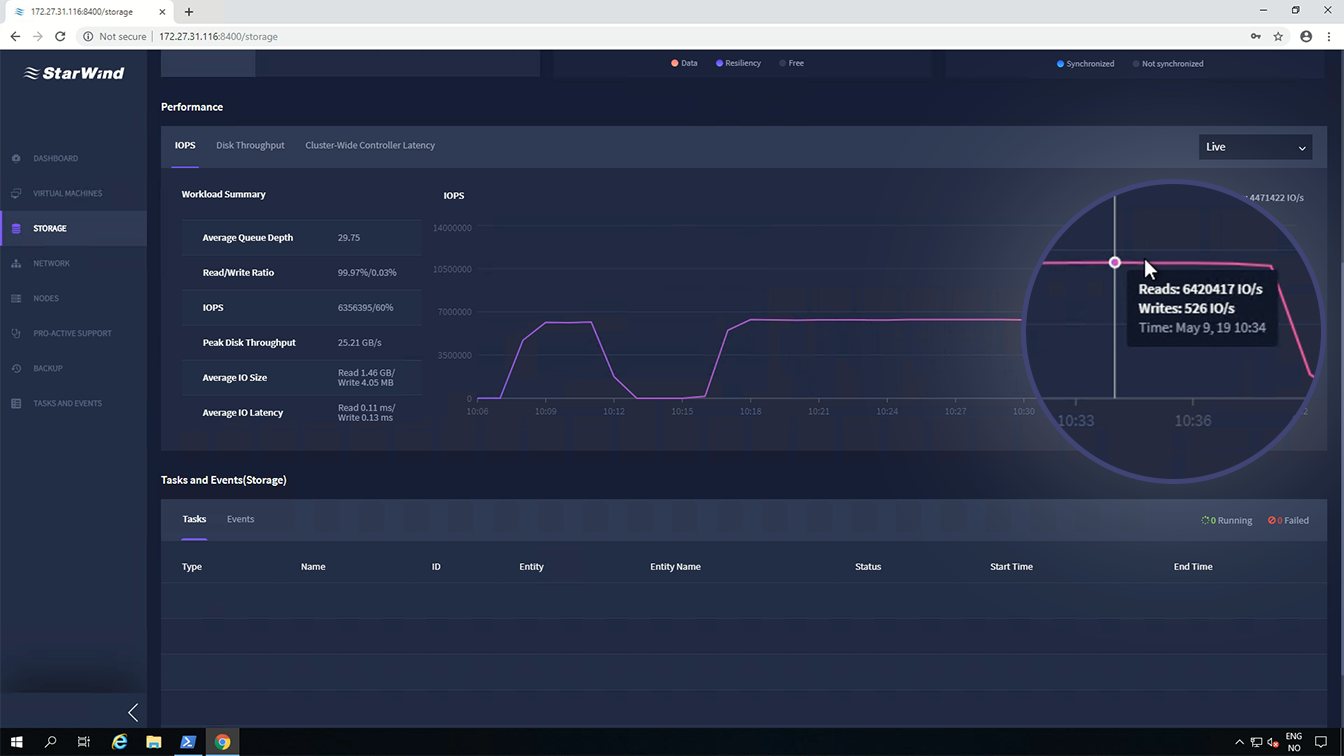

例如,StarWin命令中心存储性能操作面板具有一个交互式图表,绘制了在 Windows 中 CSV 文件系统层测量的群集范围内的总 IOPS。DISKSPD 和 VM Fleet 的命令行输出中提供了更详细的报告。

例如,StarWin命令中心存储性能操作面板具有一个交互式图表,绘制了在 Windows 中 CSV 文件系统层测量的群集范围内的总 IOPS。DISKSPD 和 VM Fleet 的命令行输出中提供了更详细的报告。

存储性能的另一面是延迟--一个IO需要多长时间才能完成。许多存储系统在重度排队下表现更好,这有助于最大化堆栈每一层的并行性和繁忙时间。但是有一个权衡:排队会增加延迟。例如,如果你能在亚毫秒级延迟的情况下做到100 IOPS,如果你能容忍更高的延迟,你可能也能达到200 IOPS。

存储性能的另一面是延迟--一个IO需要多长时间才能完成。许多存储系统在重度排队下表现更好,这有助于最大化堆栈每一层的并行性和繁忙时间。但是有一个权衡:排队会增加延迟。例如,如果你能在亚毫秒级延迟的情况下做到100 IOPS,如果你能容忍更高的延迟,你可能也能达到200 IOPS。

操作2: 4К random read/write 90/10 --> .\Start-Sweep.ps1 -b 4 -t 2 -o 32 -w 10 -p r -d 900

操作2: 4К random read/write 90/10 --> .\Start-Sweep.ps1 -b 4 -t 2 -o 32 -w 10 -p r -d 900